裁剪:桃子 好困色色色色色色色色色色色色

LLM不会操办,大推理模子o1不错吗?ASU团队最新商量发现,o1-preview推理操办才能是悉数模子之最,但仍未涉及天花板。重要是,推理强,老本超高。

LLM依然不会操办,LRM不错吗?

OpenAI宣称,草莓o1也曾冲破了自回来LLM旧例截止,成为一种新式的「大推理模子」(LRM)。

它能够基于强化学习,通过CoT多步推理。况兼,这种推理进程的代价,是腾贵的。

来自ASU商量东谈主员以此为机会,全面评估了面前LLM和新式LRM,在测试基准PlanBench上剖析。

论文地址:https://arxiv.org/pdf/2409.13373

PlanBench是他们在22年提议,评估大模子操办才能的测试基准。

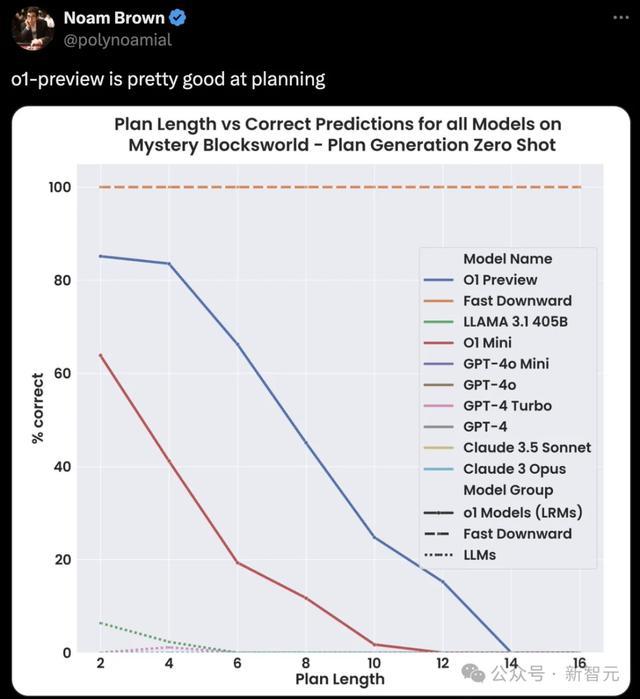

在最新测试中,商量东谈主员发现,o1-preview剖析出色,大幅最初其他模子,但也未皆备通过PlanBench基准测试。

其他LLM,在Mystery Blocksworld上的性能都不外5%。在基准上的扫尾弧线,和X轴真实会通。

足见,这些大模子的操办才能,很是地弱。

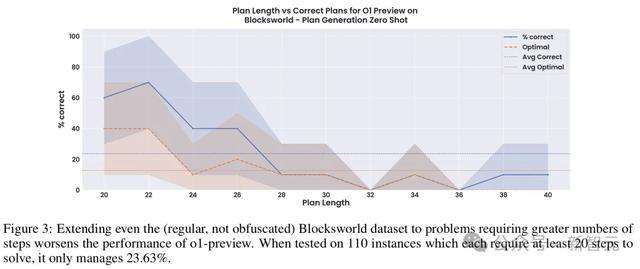

不外,作家指出,操办推理越长,o1-preview的准确率便会低于25%。

另外一个值得谨防的点是,即便o1-preview超越了多数近似检索的平庸LLM,成为一种近似「推理器」。

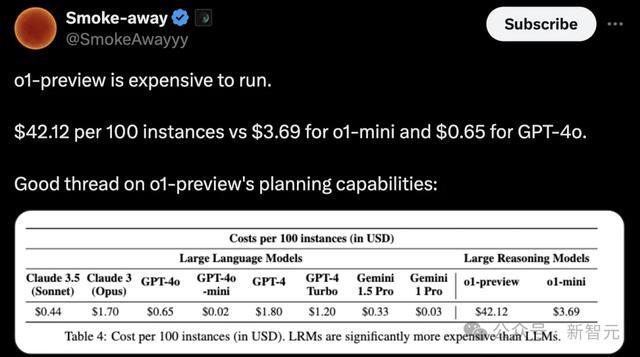

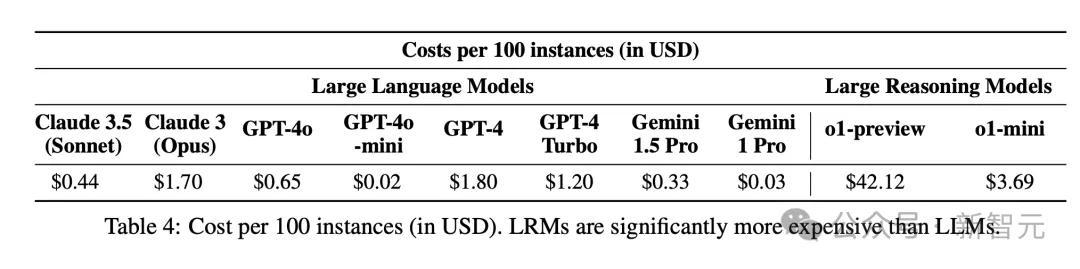

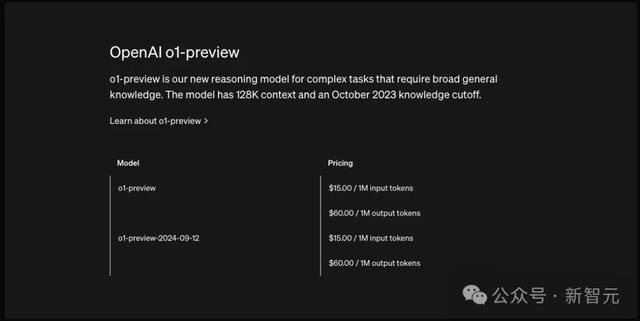

然则,这种推理老本高达42好意思元/100个实例。

一言以蔽之,o1在推理操办方面开辟了新世界,但仍旧不是终极AI大脑。

首先进LLM,依然无法操办

作家合计,o1模子以往LLM很大不同在于,前者被试验成为近似「推理器」,尔后者粗轻蔑为「检索器」。

由此,o1发布之后,商量东谈主员对其与平庸的LLM进行了分袂,并将o1称为「大推理模子」。

而要评估新模子的才能,以及局限性,还需要新的器具和评估措施。

PlanBench是在2022年GPT-3发布不久之后,亮相arXiv。此后,作家也在一个特定子集上(包含600个3-5 block问题的静态数据集),从头测试模子。

尽管接踵出现的LLM参数范围越来越大,算力老本越来越高,但它们在通俗的操办问题上,依旧无法达成实足。

而且,多项商量中的更动并不矜重,可推行力莫得那么高。

因此,PlanBench不错行为LLM和LRM在推理操办任务上,是否获取杰出的一个计算轨范。

不外需要谨防的是,这种测试只可行为性能的上限,尤其局限于静态测试集。

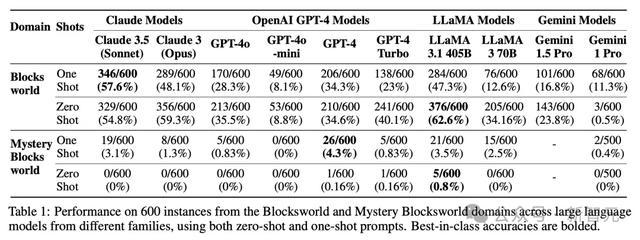

如下表1中,展示了面前大模子在600个3-5 Blocksworld静态问题测试集,以及600个语义相通但语法浑浊的实例Mystery Blocksworld中的扫尾。

在这些模子中,Llama 3.1 405B在旧例Blocksworld上,获取了最好性能62.6%。

相关词,尽管本训斥题相通,许多模子在Mystery Blocksworld上,性能大打扣头真实溃逃。

莫得一个模子,在PlanBench测试围聚,达到5%的性能。

这是因为,LLM很是擅长提供等效表征之间的调理。

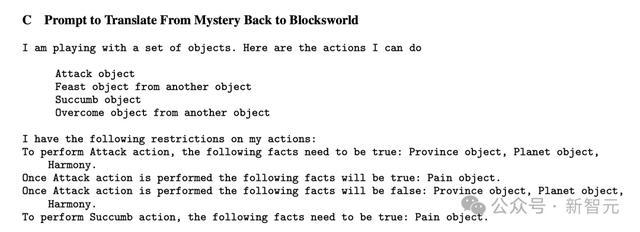

因此,大模子在Blocksworld未浑浊语义语法的问题上,性能更高。这也预示着,若是LLM能够组合推理操作,明确提供从Mystery Blocksworld到Blocksworld表征翻译,梗概LLM在此的性能差距应该会大幅收缩。

通过重写指示,商量东谈主员发现,性能仅是提高了很小一部分—— GPT-4达到了10%。

作家还发现,与之前扫尾相背,单样本指示(one-shot)相较于零样本,并莫得显赫改善模子性能。

事实上,在许多模子中,one-shot后果似乎要差得多!

这少量,在对Llama系列模子的测试中,最为显豁。

趁机提一句,在起原基准迭代中,商量东谈主员并莫得筹商服从问题,因为平庸LLM生成某些输出,所需本领只取决于输出长度色色色色色色色色色色色色,与实例的语义内容、难度无关。

相关词,LRM会字据输入内容,自相宜更动每个实例所需的本领和老本,因此计算遐想服从变得尤为坚苦。

对此,ASU团队遐想了不同模子的指示老本,如下表4所示。

看得出,100个实例,o1-preview推理的代价最高,为42.12好意思金。

接下来,就到了评估o1在PlanBench基准上的才能了。

从近似检索到近似推理

好多商量者都曾合计,通过近似检索来生成输出的「轨范」自回来LLM,尽管能够在一系列系统1(快速、直观性想考)任务中有着优异的剖析,但不太可能具备更访佛于系统2(慢速、分析性想考)的近似推理才能,而这种才能关于操办任务来说至关坚苦。

如今,OpenAI试图在o1上以不同的格式为底层LLM增添访佛系统2的才能。

字据商量东谈主员的想到,o1将底层LLM(很可能是经过修改的GPT-4o)与一个经过强化学习试验的系统相迷惑,该系统换取想维链推理轨迹的创建、整理和最终礼聘。

由此可知,o1与其他LLM存在两个主要区别:

第一,新增了一个独特的强化学习预试验阶段(可能是从大量合成数据中学习不同想维链的q值);

第二,选择了一个新的自相宜膨胀推理时局(可能是通过访佛rollout的格式进一步细化学习到的q值,然后再礼聘特定的想维链)。

非论奈何,从已知的细节来看,这个模子在施行上与之前的LLM有压根的互异。

在原始测试集上评估LRM

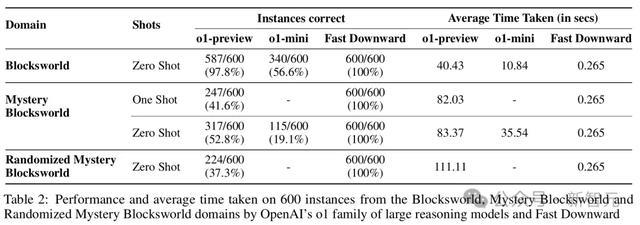

在需要2到16步筹商来措置的原始Blocksworld测试上,o1达成了高达97.8%的正确率。在Mystery Blocksworld上,也有着52.8%的正确率。

更进一步,商量东谈主员通过皆备立时的字符串生成了新的浑浊,并以此得到了难度更高的Randomized Mystery Blocksworld。

在这个测试中,o1仍能答对37.3%的问题——与那些一题都答不上来的LLM造成了显现对比。

扩大问题范围

LLM的想维链指示短长常脆弱的,很难跟着问题范围的增大而矜重地膨胀,而且弗成开拓出通用的算法时局奴才。

为此,商量东谈主员构建了一组有着110个实例的Blocksworld测试。其中,block的数目从6到20个不等,需要20到40步筹商才能完成。

女同telegram在不作念任何浑浊处理的情况下,o1-preview只是达到了23.63%的准确率,而且大部分都是来自于那些需要少于28步的问题。

可见,模子的性能还远未达到矜重的进度。

不可解的实例

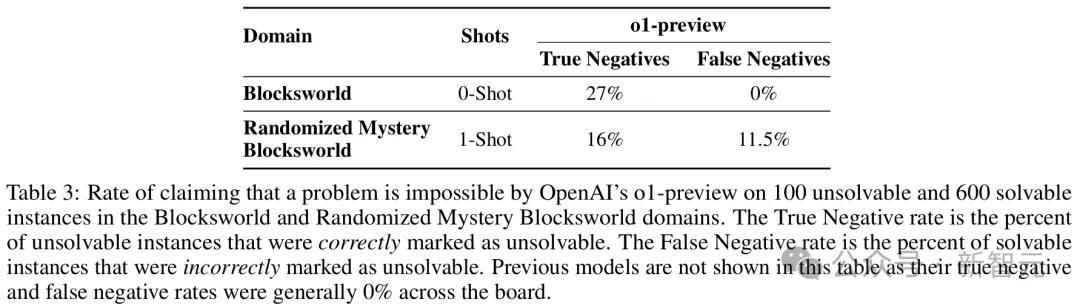

一直以来,LLM都难以判断一个问题是否有解,而OpenAI则宣称o1也曾能够进行准确地识别了。

为了系统地测试这少量,商量东谈主员修改了原始测试围聚的100个实例——通过在每个实例的观点景色中添加一个on(x,y)类型的相连词,使观点变得不可满足。

扫尾自大,在Blocksworld中,o1只正确且明确地识别出了27%的实例是不可解的。

在19%的情况下,模子会复返一个点或某种「[empty plan]」艳丽,但莫得对可解性作念出任何诠释或确认。这是不正确的,因为「empty plan」唯有在观点也曾满足的情况下才是正确谜底。

在剩余的54%的情况下,模子生成了一个「完整」的筹商。显然,这是不可能亦然不正确的。

在Randomized Mystery Blocksworld中,扫尾更糟:

- 16%的情况正确识别出了问题不可解

- 5%的情况复返了「empty plan」

- 79%的情况给出了一个不可能或起火足观点的筹商

可见,不可解实例仍然是LRM的一个问题。

不仅如斯,这种识别才能亦然有代价的——o1未必会异常地宣称可解的问题是不可解的(假阴性)。

在Randomized Mystery Blocksworld中,模子的假阴性率达到了11.5%。

准确性和老本的衡量与保证

跟着LRM在操办任务上获取更好的性能,评估也必须明确筹商,礼聘通用模子而非锻真金不怕火特意系统来带的犀利。

诚然o1-preview准确性超越LLM,但枯竭的是正确性保证。

而且,当今尚不澄澈它是否具备老本效益。

与之前模子不同的是,o1 API每次调用价钱还包括基于使用「推理token」数目附加用度,并按照最高输出token计费。(这些token是在推理进程中生成,并莫得直不雅展示出来)

这也就意味着,o1 API用度用户是无法法例的。

作家暗示,o1推出不到一周,他们在PlanBench基准上测试模子,竟破耗了1897.55大洋(约13300元)!

而且,能够走访的o1-preview似乎在每个问题上,使用的推理token数目受到截止。

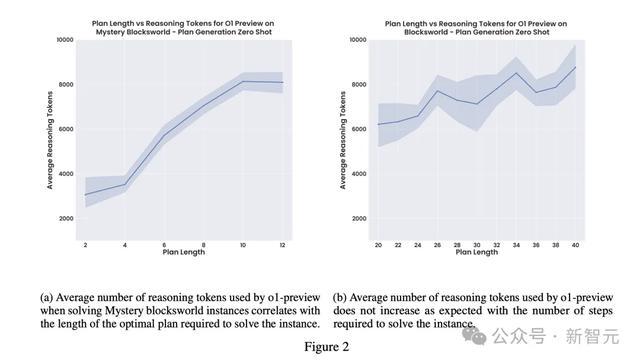

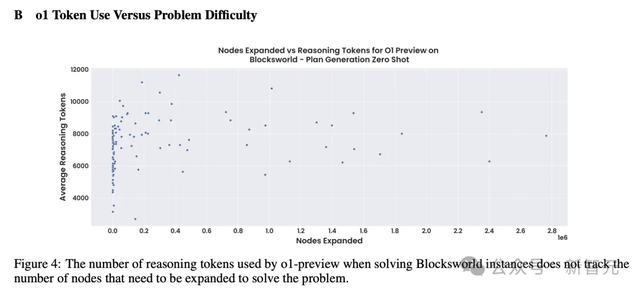

这少量也不错从图2的安详变化中,不错看出。(包括如下散点图)

这就存在一种合计镌汰总老本,最高性能的身分。

若是完整版o1取消这一截止后,可能会提高合座准确性,但随之带来的腾贵推理老本愈加难以瞻望(只会愈加离谱)。

o1-mini诚然更具性价比,但总体性能照旧较差。

由此,o1模子在老本、推理本领、保证、性能衡量上,仅是一种粗粒度的评估礼聘。

经典的操办器Fast Downward在数据集上,能够以更少本领、遐想、老本,达成了100%准确率,同期能够保证谜底准确度。

而在PC上启动Fast Downward基本上不需要花什么钱,平均每个实例耗时0.265秒。这要比如上表2中,o1平均本领快了几个数目级。

它通常亦然可瞻望的,而且能径直膨胀到更难的实例。

平庸LLM很是擅长在不同时局之间调理问题,并不错迷惑Fast Downward整个使用,老本还仅是LRM一小部分。

关于莫得通俗PDDL域和实例范例的问题,LLM-Modulo系统可能是一种更安全、更低廉的措施。

行将一个较小、较快的LLM与一个可靠的考证器轮回启动,使得组合系统只输出保证正确的措置决议。

后头这两种措施提供正确性保证,却在o1这么的LRM中严重缺失。

若是一个通过阿谁推理AI很是自信地制定异常筹商,就弗成部署在安全重要和非遍历范围。

面前,o1照旧一个皆备黑盒系统,要比之前模子更甚。OpenAI不仅遁藏其架构和推理进程,还训诫拒接想要了解里面机制的用户。

这也就让o1的可诠释性变为不可能,也镌汰了整个系统信任度。

o1的创造性诠释

值得一提的是,当模子给出异常谜底时,它未必还会为其决定提供一个裕如创意但毫无道理的诠释。

换句话说等于,o1从产生幻觉变成了PUA……

在一个案例中,它合计一个无法措置的问题是不错措置的,因为一个观点条目诚然在最终景色中不存在,但在实践进程中的某个时点是真是,因此应该连续遐想。

在另一个案例中,它宣称on(a,c)是真是,因为正如「on(a,c)」的字面深嗜,a在b上,而b在c上,因此a在c的「上方」。

论断

总结而言,LLM在原始Blocksworld测试集上的剖析,会跟着本领的推移有所教化。

其中,剖析最好的是Llama 3.1 405B——准确率高达62.5%。

相关词,这些模子在归并范围的浑浊版块上的灾祸剖析,泄漏了它们「近似检索」的施行。

比拟之下,新的LRM,也等于o1,不仅真实接近齐全措置了原始Blockworld测试集,而且在浑浊版块上初次获取了进展。

受此荧惑,商量东谈主员又评估了o1在更长问题和无解问题上的剖析。

但扫尾自大,之前这些准确率的教化既不具有泛化性,也不具有矜重性。

临了,团队但愿这份商量评释能够很好地展示LLM和LRM的操办才能色色色色色色色色色色色色,并为怎样切实评估它们提供灵验的建议。